GMOインターネット、「NVIDIA B300 GPU」と「H200 GPU」の性能を検証 – 生成AIと科学技術計算における特性を公開

GMOインターネット株式会社は、同社が提供する「GMO GPUクラウド」において、「NVIDIA H200 Tensor コアGPU」(以下、H200 GPU)と、「NVIDIA HGX B300 AI インフラストラクチャ」(以下、B300 GPU)の性能検証を実施しました。この検証は、生成AIの開発から運用までの実用性や演算性能を評価するために行われ、その結果が公開されています。

実施されたベンチマークの概要

今回の検証では、以下の3つのベンチマークを通じて、各GPUの性能特性が評価されました。

- 大規模言語モデル(LLM)の学習ベンチマーク:LLMの学習効率と演算速度を測るもので、目標品質に到達するまでの学習完了時間を測定します。

- vLLM bench throughputによる推論ベンチマーク:LLM推論のバッチ処理において、単位時間あたりに生成できるトークン量(処理スループット)を評価します。

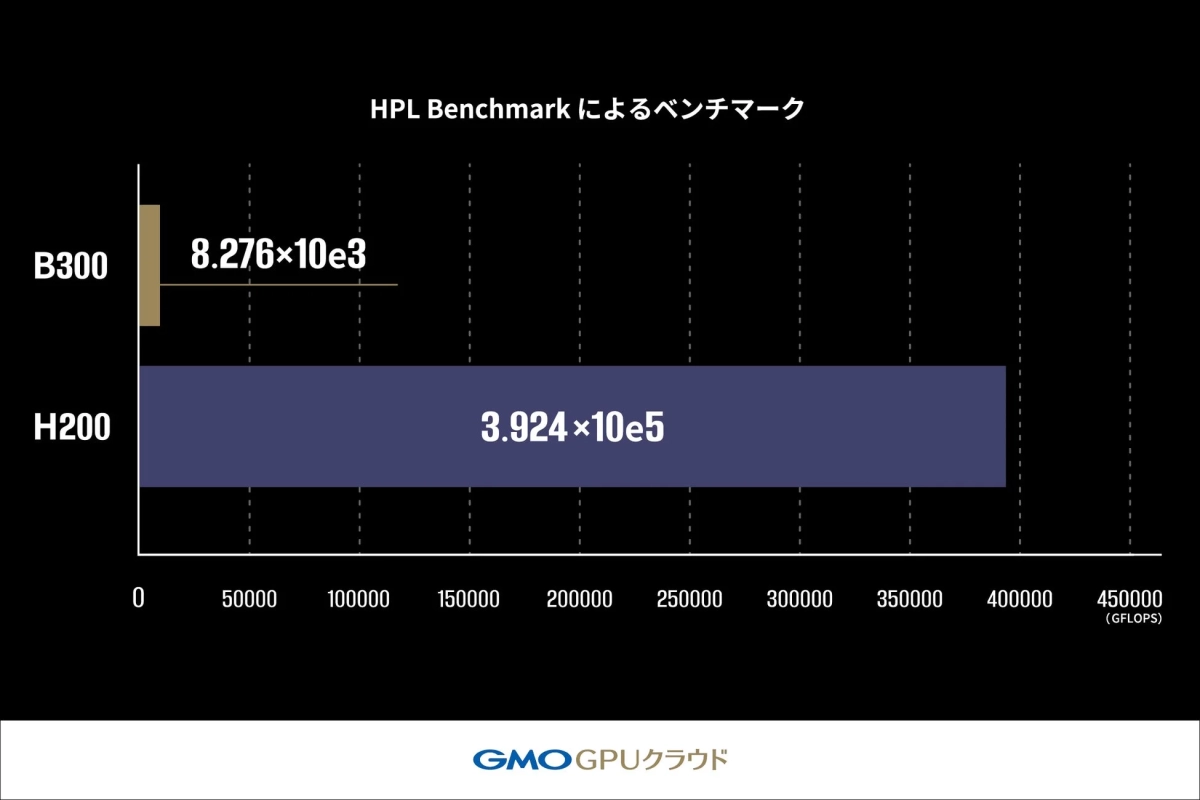

- HPL Benchmarkによるベンチマーク:高精度な数値計算の処理能力を評価するもので、浮動小数点演算性能(GFLOPS)を測定し、科学技術計算における基礎的な計算性能を測ります。

これらのベンチマークにより、生成AIの開発から運用までの実用性能と演算性能の両面から、B300 GPUとH200 GPUの特性が検証されました。この情報は、利用者がワークロードに適したGPUを選ぶ際の参考となります。

ベンチマークテストの結果

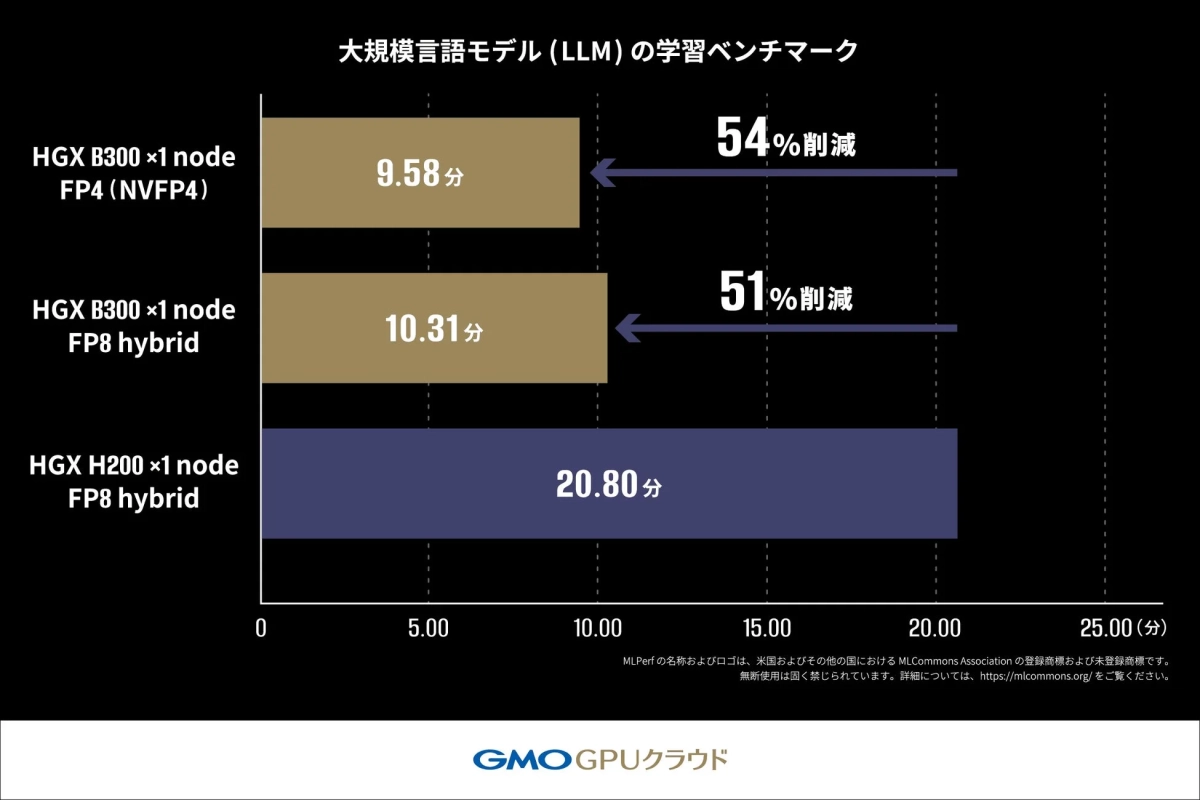

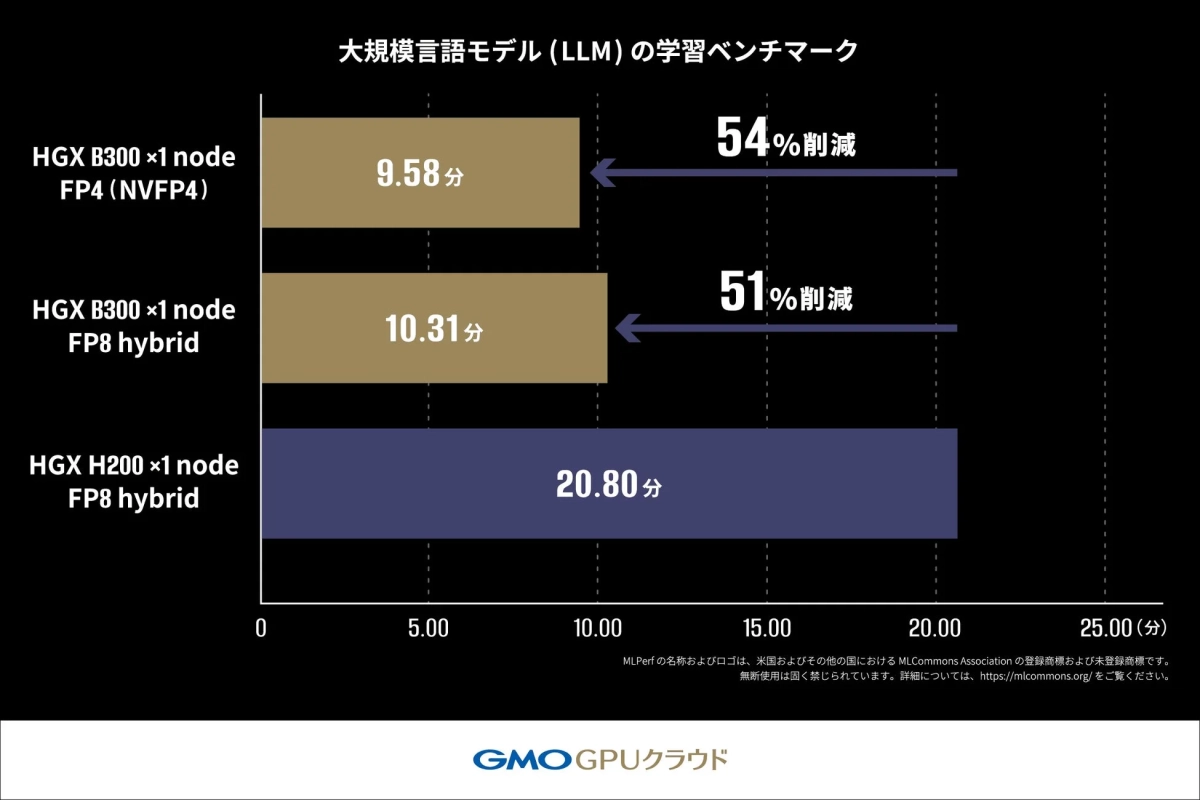

1. 大規模言語モデル(LLM)の学習ベンチマーク

このベンチマークでは、Llama2 70Bモデルを用いたLoRAファインチューニングにかかる学習時間が測定されました。その結果、H200 GPU搭載機材では20.80分かかった学習時間が、B300 GPU搭載機材では10.31分で完了し、約2倍の速度で処理が完了することが確認されました。

さらに、NVIDIA Blackwellアーキテクチャから対応したFP4(4ビット浮動小数点演算)を用いた測定では、FP8 hybrid(8ビット浮動小数点演算と高精度演算を組み合わせた混合精度学習手法)を使用した場合よりも短い時間で処理が完了しており、FP4が高い演算性能を発揮する可能性が示されています。

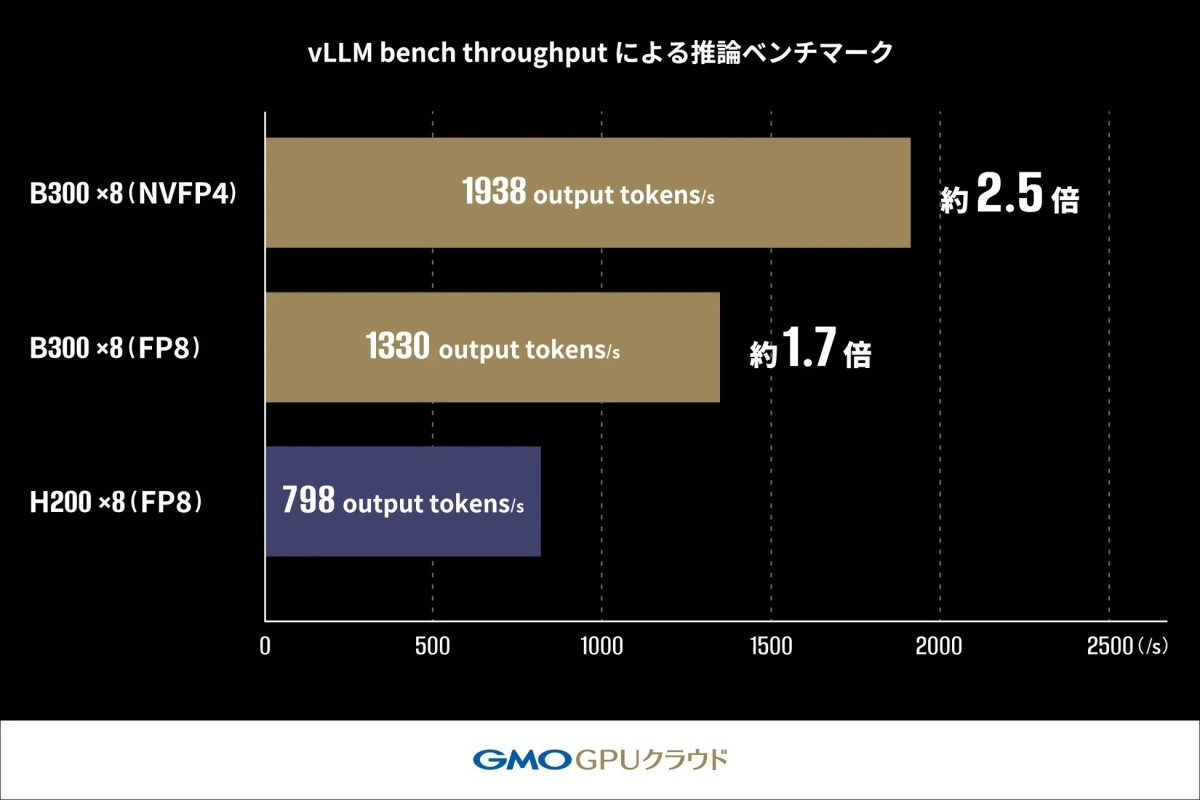

2. vLLM bench throughputによる推論ベンチマーク

vLLMのOffline Throughput Benchmarkを用いて、Llama-3.1-405B-Instructモデルの推論スループットが測定されました。H200 GPU(FP8)構成では798 output tokens/sであったスループットが、B300 GPU(FP8)構成では約170%(約1.7倍)の1330 output tokens/sまで向上しました。FP4(NVFP4)を適用した構成では1938 output tokens/sを達成し、H200 GPU構成に対し約250%(約2.5倍)の性能向上が確認されました。この結果は、FP4の活用が大規模モデルの推論パフォーマンスを向上させる有力な手段の一つであることを示しています。

3. HPL Benchmarkによるベンチマーク

HPL Benchmarkを用いて、B300 GPU搭載機材とH200 GPU搭載機材のLINPACK性能が比較されました。LINPACK性能とは、複雑な数式を正確に解く計算能力を示す指標で、スーパーコンピュータの性能評価にも使用されます。

このベンチマークでは、B300 GPU搭載機材の性能はH200 GPU搭載機材の2.1%(約47分の1)にとどまりました。これは、B300 GPUがAIワークロードに最適化された設計である一方、高精度演算(FP64)が求められる科学技術計算においては、H200 GPUが依然として適している可能性を示唆しています。

総合的な考察と今後の展開

今回の検証により、生成AIワークロードにおいてB300 GPUはH200 GPUと比較して学習で約2倍、推論では約2.5倍の処理性能を発揮することが確認されました。しかし、スーパーコンピュータの性能評価に用いられるHPL Benchmarkでは、B300 GPUはH200 GPUの2.1%の性能に留まりました。

この結果は、B300 GPUが生成AIワークロードに特化した高い性能を持つ一方で、科学技術計算のように計算結果の正確性が求められる用途にはH200 GPUが適している可能性を示しています。

GMOインターネットは、「GMO GPUクラウド」を通じて、生成AI分野に取り組む企業や研究機関に対し、ワークロード特性に応じて最適なGPUクラウドサービスを選択できる柔軟な計算環境を提供していく方針です。今回の性能検証結果を踏まえ、生成AIの学習・推論に強みを持つB300 GPUと、高精度な数値計算に適したH200 GPUを、顧客のユースケースに応じて柔軟に組み合わせて提案するとしています。単なるGPUリソースの提供だけでなく、開発目的や利用用途に応じた環境のカスタマイズから運用最適化まで、技術面・コスト面の両面で伴走支援を提供し、国内AI産業の発展に貢献していく考えです。

「GMO GPUクラウド」について

「GMO GPUクラウド」(https://gpucloud.gmo/)は、NVIDIA H200 Tensor コアGPUを搭載し、国内初となる高速ネットワークNVIDIA Spectrum-Xと高速ストレージを実装しています。

2024年11月に発表された世界のスーパーコンピュータ性能ランキング「TOP500」では世界第37位・国内第6位にランクインし、商用クラウドサービスとしては国内最速クラスの計算基盤を提供しています。さらに、2025年6月には電力効率を競う世界ランキング「Green500」にて世界第34位・国内第1位を獲得しており、高性能と省電力性の両立が国際的に評価されています。2025年12月にはNVIDIAの次世代GPU「NVIDIA Blackwell Ultra GPU」を搭載した「NVIDIA HGX B300」のクラウドサービス提供も開始しました。

- MLPerf®に関する詳細情報:http://www.mlcommons.org/

関連リンク

-

GMOインターネット株式会社:https://internet.gmo/

-

GMOインターネットグループ株式会社:https://group.gmo/

-

「GMO GPUクラウド」に関するお問い合わせ:https://gpucloud.gmo/form/